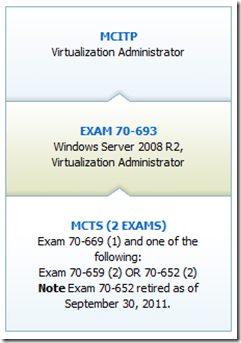

Hoje passei no exame 70-669 que abrange as tecnologias de virtualização de desktops da Microsoft. Ele é o segundo de três exames necessários para o MCITP em Virtualização.

Vou detalhar as 4 principais tecnologias que são abordadas e alguns exemplos de perguntas. Obviamente que meu exame teve uma parte das perguntas possiveis e não vou passar exatamente os cenários nem as opções.

Seguem materiais de estudos obrigatórios para este exame:

APP-V (Application Virtualization)

Este é a tecnologia que a Microsoft adquiriu a alguns anos e se chamava SoftGrid. O conceito deste tipo de tecnologia é muito interessante, mas apesar de levar o nome de virtualização é bem diferente dos modelos que conhecemos no Hyper-V e MED-V. É formado pelo App-V Manager e o App-V Sequencer.

O trabalho começa ao “sequenciar” uma aplicação e criar um pacote. Este processo nada mais é do que um monitor que ao ser iniciado passa a copiar tudo o que acontecer em um desktop. Após iniciá-lo fazemos a instalação de um software e ao final temos o pacote (package) pronto com todos os arquivos, chaves de registro e atalhos.

Exemplos de perguntas sobre o App-V:

- Um pacote ficou corrompido, qual a melhor forma de resolver?

- Como você faria para distribuir um pacote sem ter o App-V Manager no ambiente?

- Qual a ferramenta para garantir atualizações no pacote sem redistribui-lo?

Portal TechNet: http://technet.microsoft.com/en-us/appvirtualization/bb508934 e http://technet.microsoft.com/en-us/appvirtualization/cc843994

MED-D (Enterprise Desktop Virtualization)

O MED-V nada mais é do que um automatizador e gerenciador de imagens para o Windows Virtual PC do Windows 7, e é formado pelo gerenciador e pelo MED-V Workspace que fica no desktop.

Esta ferramenta irá permitir que as imagens de Windows XP criadas com aplicativos sejam distribuidas entre os usuarios. Por exemplo, imagine que duas determinadas aplicações não executem no Windows 7 e seja necessário usar o XP Mode. O MED-V ajudará a distribuir, atualizar e controlar estas VMs.

Exemplos de perguntas sobre o MED-V:

- Como fazer para converter o MED-V já existente para Cluster?

- Como otimizar a distribuição de imagens do MED-V pela rede?

- Como evitar que o MED-V consuma muito espaço em disco no servidor?

Portal TechNet: http://technet.microsoft.com/en-us/windows/bb899442 e http://technet.microsoft.com/pt-br/windows/gg276319.aspx

RDS (Remote Desktop Services)

O RDS é o Terminal Services do Windows 2008 e dispensa grandes explicações. Porem, é importante lembrar que ele é formado por vários componentes: RD Gateway para garantir acesso pela internet, RD Web Access para criar o portal de aplicações pelo browser, RD Broker para distribuir e gerenciar afinidade entre o farm, RD Session para manter os perfis dos usuários.

É importante lembrar muito bem os papeis e como cada um deles se relaciona com outro e qual a melhor forma de trabalhar com estes papeis em uma empresa.

Exemplos de perguntas sobre RDS:

- Dado um quadro de servidores com várias funções, qual deles seria colocado no Conexão da Area de Trabalho?

- Como garantir que uma impressora do usuário não seja redirecionada para a sessão remota?

- Como impedir que um pendrive seja mapeado na sessão remota?

- Quais portas e serviços adicionais precisam estar habilitados entre os papeis do RDS?

Portal TechNet: http://technet.microsoft.com/en-us/library/cc770412.aspx e http://technet.microsoft.com/en-us/edge/ff945046

VDI (Virtual Desktop Infrastructure)

Esta tecnologia pode ser facilmente explicada como uma junção do RDS com o Hyper-V para criar ambientes virtuais de desktop. Você pode criar várias VMs de Windows 7 no Hyper-V e pelo AD Users and Computers vincular os usuários as VMs quando eles acessarem pelo RDS.

Esta foi a parte do exame que teve menos perguntas, já que o processo de VDI da Microsoft é extremamente simples de ser criado e configurado. Também não é facil encontrar documentação sobre isso, porem no Edge existem muitos vídeos.

Exemplos de perguntas sobre VDI:

- Como fazer o licenciamento “per-user” e “per-device”, revogar de um ou outro e implementar?

- Qual a melhor forma de transferir dados de uma VM para outra?

- Como fazer com que um atalho apareça para todos os usuários?

Portal TechNet: http://technet.microsoft.com/en-us/edge/ff945049

É isso ai, bom exame e me conte se passou!!!